本記事は gLupe 製品サイトに移行いたしました。

記事は以下のリンクからご覧いただけます。

Shares

Editor

POPULAR POSTS

TAG

4K

AI

Android

ASTRODESIGN

AWS

CNN

CUDA

Deep Learning

eラーニング

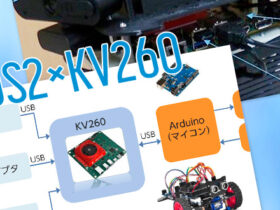

FPGA

gLupe

GPGPU

Intel Core Ultra

Jetson TX1

M2M

NPU

OpenVINO

ROBUKEY STUDIO

ROBUSKEY

ROS

ROS2

Unity

イベント

エッジAI

クロマキー

クロマキー合成

クロマキー背景

グリーンバック

データサイエンス

ビッグデータ

プラグイン

ベンチマーク

ロボティクス

写真deスタジオクロマキー

加速度計

拡大縮小

数理最適化

機械学習

物体検出

珠肌

画像処理

組込装置

美肌

量子コンピューティング

量子化