「ビッグデータEXPO東京 2015春」に展示しました「Deep Learningを利用したハンドサイン画像認識のデモ」について、全三回に分けて解説します。

今回は第一回です。シリーズ概要とデモ全体の概要について解説します。

by NagasawaKazuki 2015/04/20

はじめに

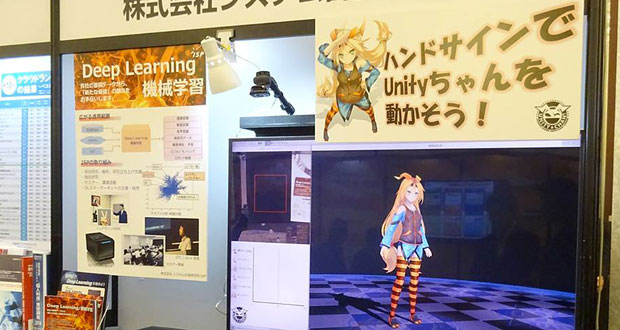

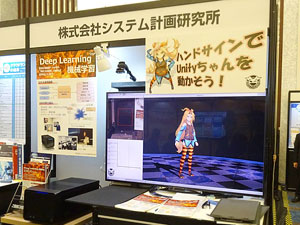

ISPは、2015年3月12日(木)、13日(金)にザ・プリンスパークタワー東京で開催された「ビッグデータEXPO 東京」に出展しました。

ブースでは「Deep Learningを利用したハンドサイン画像認識のデモ」と「Deep Learningスターターキット」を展示し、多くの方に来訪していただきました。

当日の様子とブース

本連載では、ブースで展示していました「Deep Learningを利用したハンドサイン画像認識のデモ」について、技術的な内容を含めて全三回に分けて解説します。

シリーズ構成

本連載の構成です。

[第一回]Deep Learningとは、デモ概要、ハードウェア構成 (本記事)

[第二回]デモアプリケーション

[第三回]ハンドサイン画像の学習、当日の様子

Deep Learningとは

Deep Learningとは、多層ニューラルネットワークを利用した、機械学習の一手法です。大量のデータから規則や判断基準を自動的に抽出することができます。

一般物体認識や手書き文字認識、音声認識など、様々な分野のコンテストで成果を出しています。画像や音声、時系列等、ベクトル形式となるデータならどんなものでも与えることができるため、多くの分野への応用が期待されています。

今回のデモの画像認識だけで見ても、

- 「一般人/怪しい人」の画像を学習させて、防犯に利用する。

- 車載カメラを用いて道路状況を学習し、危険予測に役立てる。

- 今回のデモの応用で、更に複雑なハンドサインを学習させることで、機器の(複雑な)操作をハンドサインで行えるようにする。

等、様々な分野への応用が考えられます。

Deep Learningについて、詳しくは当社にて開催されたセミナー資料をご覧ください。

https://wazalabo.com/deep-learning-seminar-report-001.html

デモ概要

今回の展示では、Deep Learningを用いて事前にハンドサイン画像を学習させた結果を利用して、Webカメラからの映像をリアルタイムで認識し、キャラクタを動かすデモを行いました。

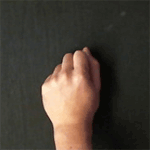

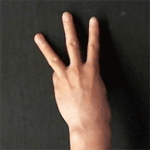

認識できるハンドサインは指を立てた本数によるもので、「0本から5本」の6パターンとなっています。

(実際には、6パターンに加え、「NGパターン (6パターン以外)」と「背景」を加えた8パターンを学習させました。)

学習させた画像の例。左から 0本、1本、…、5本、NGの一例、背景

ハードウェア構成

今回のデモは、ブースで同時に展示していました「Deep Learningスターターキット」を用いてDeep Learningの学習から当日の画像認識まで行いました。

以下が今回使用したDeep Learningスターターキットの構成です。

| CPU | XeonE5-1620V3 4Core 3.5GHz |

|---|---|

| GPU | Tesla K8 1536 Core 8GB 単精度 2.13TFlops |

| チップセット | X99 Express Chipset |

| メモリ | 16GB (4GB x 4) DDR4-2133 Quad-Channel |

| HDD | 1TB |

| OS | CentOS 7 |

| その他 | CUDA 6.5、cuDNN、Caffe インストール済み、Webカメラ接続 |

Deep Learningの学習では大量の積和演算を行う必要があり、その演算にGPUを使用することで高速に処理を行うことができます。また、Deep Learningの認識に関しては演算の必要が無いため、コンパクトで安価なハードウェアでも実行は可能です。

まとめ

本記事では、ビッグデータEXPOにて展示したデモについての概要をDeep Learningの紹介と合わせて説明しました。

次回は、デモアプリケーションの内容を解説します。

Deep Learningによるハンドサイン画像認識デモ 解説 (第二回)

- Deep Learningによるハンドサイン画像認識デモ 解説 (第一回)

- Deep Learningによるハンドサイン画像認識デモ 解説 (第二回)

- Deep Learningによるハンドサイン画像認識デモ 解説 (第三回)

今回のデモアプリケーションでは、キャラクターとして「ユニティちゃん」を使用しています。